IS-O CONSULTING

Unternehmensberatung zur IT-Unternehmens-Nutzen/Kosten-Optimierung

Methodischer Lösungsansatz

Aufgabenstellung in Zahlen

Im Jahre 2014 werden für die IT weltweit, laut Gartner Inc., dem größten IT-Marktforscher, ca. $ 3.750 Milliarden ausgegeben. Das ist etwa so viel wie das Brutto-Inlands-Produkt Deutschlands, der 4.größten Volkswirtschaft, und wesentlich mehr als der weltweite Umsatz der gesamten Automobil-Industrie. Dabei legitimiert den Aufwand für die IT als sogenannter "Querschnitts-Technologie", angemessener erscheint uns die Bezeichnung "Wertbeitrags-Technologie", insbesondere "nur" ihr Nutzen oder Wertbeitrag für die Unternehmen und Staaten. Dieser Nutzen in den Unternehmen entsteht i.d.R. durch die bessere Informationsverarbeitungs-Unterstützung bestehender Geschäfts-Prozesse oder durch die Chance, neue effektivere Lösungsansätze für die Informationsverarbeitung in den Unternehmen zu realisieren, d.h. insgesamt betrachtet überwiegend durch Produktivitätssteigerungen im weitesten Sinne des Wortes. Das Verblüffende an dieser Situation besteht nun darin, dass es nach wie vor unbekannt ist, welchen Unternehmens- und Staats-Nutzen dieser inzwischen beeindruckend hohe Aufwand erwirtschaftet!

Unsere inzwischen über 30 Jahre lange Beschäftigung mit dieser Fragestellung hat ergeben, dass es dabei um die Lösung zweier grundsätzlich unterschiedlicher Aufgabenstellungen geht: Zum Einen und vor allem um die "Hebung" des IT-Effektivitäts-Potentials der Unternehmen, d.h. um die Realisierung der Potentiale aller IT-Funktionalitäten und des immer besser werdenden Preis-Leistungs-Verhältnisses bis zum Optimum, als Zwischenschritt zumindest bis zum Niveau "Best-Practice", bzw. „Best-Enterprise-Benefit“. Und zum Anderen um die "Beseitigung" von IT-In-Effizienzen, die in den letzten Jahrzehnten die Hauptaufmerksamkeit auf sich gezogen haben, anscheinend auch als Alibi-Aktivität in Ermangelung der Fähigkeiten zur Realisierung der IT-Unternehmens-Nutzen-Darstellung.

Nach unseren Forschungs-Ergebnissen zu den Zielsetzungen "IT-Effektivitäts- und IT-Effizienz-Verbesserungen in den Unternehmen bis zum Optimum", mit dem Niveau "IT Best Practice in den verschiedenen Ausprägungen" in der deutschen Versicherungsbranche als Zwischenergebnis, gibt es gegenwärtig die folgenden unausgeschöpften IT-Unternehmens-Nutzen/Kosten-Potentiale: Beim IT-Einsatz ein unausgeschöpftes IT Effektivitäts-Potential von im Durchschnitt mindestens 44%. D.h. hochgerechnet auf den gesamten IT-Einsatz bei den Unternehmen (ohne Kommunikationstechnik), der etwa 20% von gegenwärtig $ 3.700 Mrd, also etwa $ 740 Mrd beträgt und ein ROI-Potential von nach unseren Erkenntnissen mindestens 4:1 aufweist. Ein unausgeschöpftes IT-Effektivitäts-Potential von mindestens $ 1.300 Milliarden. Zu dessen Realisierung wären zusätzliche IT-Investitionen von 68% oder $ 505 zu erbringen. Da mit unserem Methodischen Lösungsansatz zusätzlich die Erkenntnis verfügbar wird, dass es auch immer noch ein IT-Effizienz-Potential von im Durchschnitt 43% gibt, was in etwa $ 270 Milliarden entspricht, ließe sich die Realisierung des zusätzlichen IT-Wertbeitrags der Unternehmen (und Staaten) für nur $ 235 Milliarden, also mit einer kaum zu überbietenden Profitabilität, durchführen.

Bei diesen Extrapolationen handelt es sich um repräsentative Größenangaben und sie sind zugegebenermaßen herausfordernd, da sie auf einem begrenzten Sample basieren, einerseits. Andererseits dürfte es sich um die bestfundierten Abschätzungen handeln, die es nach unserer langjährigen Erfahrung mit dieser Thematik derzeit überhaupt gibt. Damit erscheinen sie uns in Anlehnung an die Erkenntnisphilosophie von Karl Raimund Popper, dass "erfahrungswissenschaftliche Theorien solange gültig sind, wie sie entweder bewiesen oder nicht widerlegt worden sind", eine ausreichend legitimierte Annäherung zu sein. Diese in Zahlen gegossene Situationsdarstellung erscheint uns auch deshalb notwendig, um die bisher völlig unbefriedigende Behandlung dieser Thematik radikal zu attackieren. Wer die grundsätzliche Substanz dieser Aussagen anzweifelt, kann uns gerne zum "Diskussions-Duell" herausfordern!

Lösungstheorie

Die nach gegenwärtigem Erkenntnisstand beste Basis für die Lösung von herausfordernden Aufgabenstellungen besteht in der Entwicklung einer Lösungstheorie. Eine Theorie liefert nach Brockhaus "in gewissem Umfang eine Zusammenfassung, Beschreibung, Erklärung und Vorhersage von Phänomenen" und damit einen holistischen Überblick über eine komplexe Aufgabenstellung, wie die seit mindestens 50 Jahren einer systematischen Beantwortung harrende "Gretchenfrage" der IT:

Wie viel Geld sollte ein Unternehmen für seine IT ausgeben?

Zur Entwicklung einer Lösungstheorie bedarf es bekanntlich sowohl einer systematischen Analyse des Sachgebietes als auch einer intensiven Beschäftigung mit verschiedenen Lösungsansätzen. Uns ist es dabei nach etwa ½ Jahrzehnt gelungen, die folgende Lösungstheorie zu entwickeln, die sich seit inzwischen mehr als 25 Jahren bestens bewährt hat:

- Das IT-Nutzen-Potential eines Unternehmens ergibt sich aus der Differenz der "gegenwärtigen Zusammensetzung der algorithmisierbaren Unternehmens-Informationsverarbeitung aus Human- und Computer-Ressourcen" und der "optimalen Zusammensetzung"

Diese offensichtlich erstaunlich kurze und übersichtliche Theorie-Formulierung entspricht in ihrer Substanz der Definition des Computers nach A. Turing! Damit muss ihre Richtigkeit nicht mehr bewiesen werden. Dennoch möchten wir hinzufügen, dass diese Lösungstheorie in den mehr als 25 Jahren ihrer Existenz bei ihrer Verwendung in der Praxis auch von den zahlreichen Fachleuten der verschiedenen Fachrichtungen, insbesondere natürlich auch den Informatikern und Wirtschaftsinformatikern, die dabei beteiligt waren, niemals infrage gestellt worden ist.

"Holistischer", "Praxis-basierter Lösungsansatz" aufbauend auf den Erkenntnissen durch "Decision-Mining"

"Theorie ist gut, Praxis-Erkenntnisse sind sicher besser" könnte man an dieser Stelle sinngemäß nach Lenin einwenden. Oder: Wie lassen sich die Erkenntnisse dieser Theorie durch die Ergebnisse in der Praxis beweisen und insbesondere in den einzelnen Unternehmen umsetzen?

Dabei ist eine genauere Analyse der durch die Evolution der IT in den letzten 60 Jahren entstandenen IT-Landschaft ausgesprochen hilfreich! Denn selbstverständlich haben alle IT-Verantwortlichen der einzelnen Unternehmen jeweils mit oberster Priorität die Zielsetzung des IT-Einsatzes in ihren Unternehmen verfolgt, den IT-Unternehmens-Nutzen bestmöglich, heutzutage üblicherweise als "Best-Practice" bezeichnet, zu realisieren. Und die Anbieter von IT-Produkten und IT-Lösungen haben sie dabei teils mehr aber auch teils weniger gut unterstützt. Teils auch weniger gut insbesondere auch deshalb, weil die IT-Produkte-Hersteller aufgrund ihrer Entstehung fast ausschließlich Nischen-Produkte-Anbieter waren und auch immer noch sind und ihre Geschäftsmodelle deshalb die Zielsetzung Best-Practice bestenfalls aus ihrer punktuellen Produktsicht realisieren können und wollen, um es euphemistisch auszudrücken.

Leider muss an dieser Stelle der Situationsanalyse noch festgestellt werden, dass der Beitrag der "Öffentlich-rechtlichen Wissenschaft", d.h. insbesondere in Deutschland der "Wirtschafts-Informatik" und in den USA der Disziplinen der "Information Systems", ein vergleichbares Wissenschaftsgebiet wie "Business Informatics" gibt es in den USA übrigens nicht, bisher praktisch nicht existent ist! Daraus ergibt sich die eindeutige Erkenntnis, dass sich unseres Wissens bisher niemand - außer IS-OC - nachdrücklich und professionell um eine Antwort auf die Schlüssel-Fragen der Unternehmens-IT: "Wie lässt sich der IT-Unternehmens-Nutzen bestmöglich realisieren?" gekümmert hat, beziehungsweise: "Wie viel Geld sollte ein Unternehmen für seine IT ausgeben?"

Dieser Mangel an IT-Entscheidungserkenntnissen hat in der Praxis deshalb unausweichlich zu erheblich unterschiedlichen Ergebnissen bei der Realisierung des IT-Unternehmens-Nutzens in den einzelnen Unternehmen geführt. Nach unserer langjährigen Erfahrung und durch Einsicht in die umfangreichen Datenbestände meines ehemaligen Arbeitgebers IBM, unterscheidet sich die IT-Unterstützung pro Mitarbeiter in Deutschland um bis zu Faktor 10! Faktor 3-4 war und ist immer noch die Regel. In dieser Situation lässt sich schlussfolgernd die Hypothese aufstellen, dass der IT-Unternehmen-Nutzen bei vergleichbaren Mitarbeitergruppen beschäftigt bei vergleichbaren Unternehmen, deren IT-Einsatz sich derart gewaltig unterscheidet, klar zutage treten müsste: Und genau dieser Unterschied bei der "benötigten Anzahl von Mitarbeitern pro Ergebnis-Einheit bei unterschiedlich hohem IT-Einsatz" ist mit erstaunlicher Eindeutigkeit zutage getreten: Und dies bei allen Unternehmen, wenn sie dabei, wie beim IT-Marketing üblich, in 6 Branchen untergeteilt werden, da die Branchen die "Charakteristik von Erkenntnis-Domänen" repräsentieren! Die hiermit gewonnenen Erkenntnisse sind somit das Ergebnis von "Decision-Mining mittels Benchmarking"

(siehe Abbildungen Start-Seite)

Aus den Ergebnissen dieser Untersuchung lässt sich, wie sofort erkennbar ist, ein völlig neuartiger Lösungsansatz zur Beantwortung der "Gretchen-Frage der IT: Wie viel Geld sollte ein Unternehmen für seine IT ausgeben?", entwickeln: Nämlich ein durch "Decision-Mining mittels Benchmarking" gewonnener, "faktenbasierter", "holistisch deduktiver", "Praxis-basierter" Methodischer Lösungsansatz!

Dieser Ansatz hat die folgenden fundamentalen Merkmale bzw. Vorteile:

- Es ist ein "Holistischer Ansatz" oder Top-down-Ansatz.

- Die "Erkenntnisse werden mittels Decision-Mining gewonnen und sind Praxis-basiert", d.h. sie bilden die real-existierenden Situationen in einer Domäne ab.

- In einem Holistischen Ansatz lässt sich durch "Benchmarking" die "Kollektive Intelligenz der Beschäftigten einer Domäne", üblicherweise die Erkenntnisse einer Branche oder Subbranche, darstellen und einsetzbar machen.

- Das Benchmarking der Unternehmen einer Domäne ergibt v.a. die folgenden Entscheidungs-Erkenntnisse:

- Die fundamentale Erkenntnis: "Best-Benefit (Best Practice)" in allen ihren vielfältigen Versionen (siehe Kap. BP),

- ein "IT-Rating" der einzelnen Unternehmen und damit eine eindeutige Aussage über den Handlungsbedarf,

- die Darstellung des "unausgeschöpften IT-Nutzen-Potentials eines Unternehmens" in "Business Case-Form".

- da die Korrelation "benötigte Anzahl Mitarbeiter vs IT-Einsatz" in einem 2-dimensionalen Diagramm dargestellt wird, lässt sie sich zu einer "Durchschnittskurve" komprimieren: Daraus ergeben sich auch qualifizierte Erkenntnisse über "legitime Zielsetzungen jenseits des Best-Benefit-Niveaus."

- Ein holistischer Ansatz beinhaltet theoretisch die Antworten auf alle Fragen, die in dem Sample abgebildet sind. Die Antworten auf die Fragen lassen sich relativ einfach durch Differenzierung des holistischen Ansatzes gewinnen.

- Ein holistischer Ansatz erlaubt es insbesondere, Fragestellungen durch relativ einfache "Heuristische Modelle" abzubilden, wobei die Aussagegenauigkeit und damit der Datenaufwand vorgegeben werden können.

- Die Erkenntnisse eines holistischen Ansatzes lassen sich mit relativ wenig Aufwand fortschreiben.

- Das Controlling bei der Realisierung des IT-Unternehmens-Nutzens ist Ansatz-immanent.

- Die Realisierung der IT-Umsetzungs-Effizienz bis zum Best-Practice-Niveau ist natürlich ebenfalls Teil dieses holistischen Ansatzes und ist in ihrer Struktur ein Teil der IT-Unternehmens-Nutzen-Realisierung-Architektur.

- Da dieser Methodische Lösungsansatz ausschließlich aus Fakten und Algorithmen besteht, sind seine Realisierung und die Fortschreibung der Erkenntnisse ausschließlich über das Internet, in der Cloud von IS-OC, mit bester Umsetzungs-Effizienz möglich.

Dieser Methodische Lösungsansatz, der den "erfahrungswissenschaftlichen Anforderungen nach K.R. Popper" entsprechen dürfte, ist der unseres Wissens erste und bisher einzige, der das Prädikat "Decision-Mining-basiertes IT-Consulting" mit der "Zielsetzung einer IT-Unternehmens-Nutzen/Kosten-Optimierung" verdienen dürfte!

Dieser Lösungsansatz ist erkennbar zunächst nur ein relativer Lösungsansatz: Allerdings einer, der aufgrund seines "Decision-Mining basierten","holistischen Ansatzes" sehr viel mehr IT-Entscheidungserkenntnisse zur Verfügung stellt als die anderen bisher üblichen, die von ihrem Wesen her "induktive Lösungsansätze" sind. Sein Potential zur Bereitstellung von Erkenntnissen ist dabei zunächst eine Funktion der Unterschiede der Ergebnisse der Unternehmen eines Samples. Wenn es keine Unterschiede mehr gäbe, weil alle Unternehmen das Niveau der IT-Best-Benefit erreicht haben, dann gäbe es in der Tat auch scheinbar keine Orientierungs-Zielgröße mehr. Diese Situation ist aber nach aller Erfahrung mit der bisherigen Entwicklung der IT eine äußerst theoretische und so unwahrscheinlich wie beispielweise die Situation, dass alle Unternehmen einer Branche die gleiche Wettbewerbsfähigkeit erreicht haben.

Außerdem wird in der Praxis sofort erkennbar, dass die Realisierung von IT-Best-Benefit-Lösungen immer auch eine fortschrittsfreundliche Unternehmenskultur voraussetzt und die konsequente Förderung innovativer Lösungsansätze. Diese Förderung könnte natürlich auch durch externe Fachleute oder Interessenten, wie IT-Firmen durch systematische Zusammenarbeit erfolgen. Und selbstverständlich könnten schließlich auch die Universitäten und staatlichen Forschungseinrichtungen ihren Beitrag leisten, was bei Rückschau auf die IT-Beiträge der letzten ca. 45 Jahre aber leider als eher unwahrscheinlich eingeschätzt werden muss.

Die Erkenntnismächtigkeit dieses Methodischen Lösungsansatzes, seine Struktur und die Vorgehensweise, mit der sich die verfügbar werdenden Erkenntnisse individualisiert für jedes einzelne Unternehmen bereitstellen und systematisch in der Praxis realisieren lassen, wollen wir nachfolgend offenlegen, wobei die Spielregeln zum Schutz geistigen Eigentums gelten.

Methodischer Ansatz zur Umsetzung

Diese Lösungstheorie liefert Ansatz-immanent auch die Struktur des Lösungsansatzes: Zu korrelieren sind erkenntlich die Human-Ressourcen für die algorithmisierbare Informationsverarbeitung eines Unternehmens mit den alternativ dazu einsetzbaren Computer-Ressourcen. Daraus folgt die Notwendigkeit einer 2-Dimensionalität des Lösungsansatzes.

Und da die aktive Größe der Einsatz der Computer-Ressourcen ist, wird sie üblicherweise auf der x-Achse abgebildet. Die dadurch beeinflusste Größe der Human-Ressourcen ist somit auf der y-Achse aufzutragen.

Eine der größten Herausforderungen bei der Lösung komplexer Aufgabenstellungen besteht bekanntlich in der Konstruktion einerseits möglichst leistungsfähiger und andererseits möglichst einfacher Maßstäbe: Diese 2 Zielsetzungen repräsentieren fast ein Oxymoron. Viele Lösungsansätze scheitern bereits an dieser Stelle eines Lösungsversuches. Bei der vorliegenden Aufgabenstellung gibt es, wie man bei einigem Räsonieren herausfinden kann, 2 Vorgehensansätze, denen wir die Bezeichnung "absoluter Ansatz" und "relativer Ansatz" geben wollen.

Auf den "absoluten Ansatz" stößt man zunächst praktisch "zwangsläufig", da er bei der von der Theorie vorgegebenen Vorgehensweise auf der "logischen Denkstraße" liegt. Bei einem absoluten Ansatz muss man den IT-Aufwand in einem Unternehmen ins Verhältnis setzen zu den benötigten Mitarbeitern für die algorithmisierbare Informationsverarbeitung in diesem Unternehmen. Um zu der Erkenntnis von einem "optimalen Mischungsverhältnis von Human-und Computer-Ressourcen" zu gelangen, müssen die Computer-Ressourcen in diskreten Schritten gesteigert und für jeden Schritt die dafür benötigten Human-Ressourcen bestimmt werden. Spätestens an dieser Durchdenken-Position dieses Lösungsansatzes wird jeder Praktiker zu dem Urteil gekommen sein, dass dieser absolute Ansatz zu nicht mehr taugt als zu einer vielleicht interessanten Gedankenspielerei, da die jeweiligen Human-Ressourcen-Ordinaten nicht bestimmbar sind.

Diese Schlussfolgerung stellt sich bei einer tiefer gehenden Analyse der realen Situation des IT-Einsatzes in den Unternehmen, die sich bekanntlich durch die Evolution der IT in den Unternehmen in ca. 60 Jahren herausgebildet hat, aber als voreilig heraus! Sie verstellt den Denkweg zum Erkennen eines sehr gut geeigneten Lösungsansatzes, den wir den "relativen Lösungsansatz" bezeichnen wollen. Denn die Zielsetzung eines optimalen Einsatzes der IT wird in all den Jahren in praktisch allen Unternehmen verfolgt, hat in der Praxis bemerkenswerterweise aber zu sehr unterschiedlichen Ergebnissen geführt. Wie bereits ausgeführt, unterscheidet sich die IT-Unterstützung pro Mitarbeiter, übrigens ein sehr viel besser geeigneter Maßstab für die IT-Unterstützung in einem Unternehmen als der oft verwendete IT-Aufwand bezogen auf den Umsatz, um bis zu Faktor 10! Faktor 3-4 war und ist immer noch die Regel. Daraus lässt sich die Erkenntnis ableiten, dass es die Korrelation zwischen unterschiedlichem IT-Aufwand pro Beschäftigten und der wahrscheinlich unterschiedlichen "Produktivität pro Beschäftigten", wiederum der am besten geeigneter Maßstab für die benötigten Human-Ressourcen für die algorithmisierbare Informationsverarbeitung, sehr wohl gibt, allerdings in unterschiedlichen Unternehmen angesiedelt. Die Schlussfolgerung lautet somit: Wenn man viele möglichst ähnliche Unternehmen mit möglichst unterschiedlichem IT-Aufwand pro Beschäftigten mit einander korreliert, dann müsste der Einfluss des IT-Aufwandes eindeutig zutage treten: Und genau dieses Ergebnis hat sich eindeutig eingestellt, als wir Korrelationen für die verschiedenen Branchen ausgearbeitet haben! Bemerkenswert erscheint uns an dieser Stelle der Hinweis, dass nicht nur mein früherer Arbeitgeber IBM sondern die IT-Branche insgesamt den Vertrieb und die Betreuung ihrer Kunden nach Branchen gegliedert hat, weil durch die Homogenität innerhalb der Branchen der Vertrieb und die Realisierung des Computereinsatzes am effektivsten organisiert werden kann. Aus Gründen, die noch erläutert werden, haben wir unsere Aktivitäten bisher auf die deutsche Versicherungsbranche fokussiert und deren Korrelation seit 1990 jährlich aktualisiert. Angemerkt sei an dieser Stelle auch, dass es den Vergleich unter befreundeten Unternehmen einer Branche zur Erkenntnisgewinnung schon seit mehreren Jahrzehnten gibt, unseres Wissens allerdings mit überschaubarem Erfolg, da bisher kein Vorschlag für eine systematische Vorgehensweise zur Erkenntnisgewinnung zur Verfügung stand.

Nachdem nunmehr das Korrelationsumfeld festgelegt ist, müssen wir als nächstes eine Auslegung der beiden Maßstäbe speziell für dieses Umfeld vornehmen.

Auslegung der Ordinate

Die Erkenntnisse liefernden Sample sollten also sowohl aus möglichst ähnlichen Unternehmen bestehen als auch möglichst viele Unternehmen umfassen. Wiederum einer der immer wieder auftretenden Widersprüche bei Praxis-basierten Lösungsansätzen für die bestmögliche Kompromisse gefunden werden müssen: Ein gut-geeigneter Kompromiss bei der Auslegung der Ordinate eines Samples dürfte offensichtlich in der Orientierung an den Branchen eines Staates zu finden sein.

Aber auch Unternehmen einer Branche unterscheiden sich in ihren Geschäftsmodellen und damit ihren Geschäftsprozessen in einem gewissen Umfang, der möglichst gut berücksichtigt werden sollte. Die Schlussfolgerung lautet deshalb: Als "Referenzgröße" einer Branche sollte der "Branchendurchschnitt" herangezogen und die Abweichungen von diesem Durchschnittswert durch einen "Normalisierungsfaktor" berücksichtigt werden. Dieser Normalisierungsbedarf betrifft die Ordinate, nicht dagegen die Abszisse, denn die IT-Ressourcen-Architektur der Unternehmen einer Branche unterscheidet sich i.d.R. nicht wesentlich.

Auslegung der Abszisse

Eine ganz grundsätzliche Herausforderung gibt es dagegen bei der Auslegung der Abszisse, der Festlegung des IT-Ressourcen-Aufwandes eines Unternehmens, zu bewältigen. Denn in diesem Bereich ist die seit Anbeginn der IT verwendete Semantik, ohne Euphemismus ausgedrückt, eine Katastrophe, von babylonischem Sprachgewirr nicht zu unterscheiden! Vergleichbare, nach allgemein verwendeter gleicher Definition erstellte Messgrößen sucht man da vergebens. Eine oft verwendete, zunächst überzeugend klingende IT-Messgröße heißt "IT-Budget". Sieht man sich aber die Einzelelemente, aus denen das IT-Budget zusammengesetzt ist, näher an, dann bemerkt man sofort, dass sowohl diese Einzelelemente unterschiedlich interpretiert als auch die Zusammensetzung unterschiedlich realisiert werden. Außerdem wird bei dieser Messgröße unterstellt, dass alle IT-Bereiche die Einzelelemente eines IT-Budgets, d.h. v.a. die Hardware, die System-Software, die IT-Fachleute und die Betriebskosten mit der gleichen Umsetzungseffizienz realisiert haben. Schon die Aufzählung genügt, um erkennbar zu machen, dass das nicht nur nicht der Fall sein wird sondern dass es auch in diesem Bereich sogar sehr große Unterschiede geben dürfte. Die Angebote zur IT-Umsetzungs-Effizienz-Steigerung durch zahlreiche Beratungsfirmen seit vielen Jahrzehnten sind ein eindeutiger Indikator dafür.

Schlussfolgerung: Wer für diese Aufgabenstellung einen Maßstab auf angemessenem Qualitätsniveau einsetzen möchte, muss selbst kreativ werden. Dabei sind die folgenden Herausforderungen zu bewältigen:- Es muss ein "Einheitlicher Maßstab" sein, der den IT-Unternehmens-Nutzen-Beitrag aller 4 gegenwärtig zum Einsatz kommenden Computer-Architekturen, nämlich "Mainframe", "Unix- bzw. Linux-Server", "x86-Server" und "Client/Server und PC" ausmessen kann.

- Der Maßstab muss v.a. die "IT-Netto-Ressourcen" messen können, denn nur dieser "produziert" den IT-Unternehmens-Nutzen, der mit den Human-Ressourcen zu korrelieren ist.

- Für "Mainframes", die gegenwärtig fast nur noch vom IBM angeboten werden, gibt es seit über 50 Jahren die Leistungs-Messgröße MIPS (Million Instructions per Second), von IBM zunächst in der "Messgröße MIPS" veröffentlicht und später als "relative Größenangabe" zur Verfügung gestellt. Diese Angaben gab und gibt es für alle MF! So umfangreiche und präzise Leistungsangaben gibt es bei keinem anderen Hersteller, auch nicht annähernd. Diese MIPS-Messgrößen beschreiben allerdings die Leistungsfähigkeit speziell für kommerzielle Anwendungen!

- Für "Unix-Server" gibt es mehrere Leistungsangaben und zwar sowohl von Herstellern als auch von Leistungsmessungs-Institutionen. Am genauesten sind wieder die Angaben bei IBM für die gegenwärtig angebotenen p-Systeme. Der verwendete Maßstab heißt "rPerf" (relational Performance) und die einzelnen Leistungsangaben sind z.B. im Internet zusammen mit den Computerdaten veröffentlicht. Die rPerf-Angaben gelten aber speziell für technisch/wissenschaftliche Anwendungen. Bei HP und Anderen findet sich erstaunlicherweise nichts dergleichen!

"Zum Glück" gibt es aber die Möglichkeit, über die zwei "Leistungsmessungs-Institutionen" "TPC" und "SPEC", das Ergebnis von Leistungsmessungen im Rahmen klar definierter Benchmarks einzusehen. Bei kommerzieller Aufgabenstellung sind insbesondere die Leistungsmessdaten bei TPC hilfreich. Die Ergebnisse werden z.B. im Maßstab "tpmC" (transactions per minute C-script) angegeben. - Auch für die "x86-Server" wird man bei TPC fündig.

- Hinweise über den Leistungs-Beitrag von "Client/Server und PC" lassen sich mit ausreichender Genauigkeit durch "Information Engineering" bei Kennern der Unternehmensanwendungen gewinnen.

Verbleibt "nur" noch die Aufgabe, Umrechnungsfaktoren für die verschiedenen Maßstäbe, zu entwickeln, denn selbst IBM stellt keinen Umrechnungsfaktor von rPerf zu MIPS oder umgekehrt zur Verfügung! Der Grund liegt in der unterschiedlichen Leistungsfähigkeit der Unix-Server, bei denen RISC-Architekturen realisiert sind, bei unterschiedlicher Zusammensetzung von kommerziellen und T/W-Anwendungen. Also heißt es noch einmal "Erfahrungs-Erkenntnisse aktivieren": Mit erheblichem Wissen über die Stärken und Schwächen der verschiedenen Architekturen der beschriebenen Server und der Charakteristik der auf ihnen zur Ausführung gebrachten Arbeitslast lassen sich die Umrechnungsfaktoren mit ausreichender Genauigkeit abschätzen und durch überprüfen mit der Praxis nachbessern. Anmerkung 1: Eine sehr viel bessere Lösung wäre natürlich ein Benchmark mit einer "repräsentativen Arbeitslast einer Branche" auf einer "charakteristischen Computer-Konfiguration, die die Computer aller Plattformen dieser Branche umfasst". Anmerkung 2: Die MIPS-Messungen der IBM für ihre Mainframes erfüllen diese Zielsetzung für eine repräsentative kommerzielle Arbeitslast bereits seit ca. 50 Jahren!

Als Entwicklungs- und Testumfeld für diesen Methodischen Lösungsansatz haben wir uns vor inzwischen mehr als 25 Jahren für die deutsche Versicherungsbranche entschieden, da sie uns am geeignetsten erschienen ist. Diese Entscheidung hat sich längst als richtig erwiesen. Da in der dt. Versicherungsbranche 2014 noch 49,3% aller Anwendungen auf Mainframes produziert werden, bleiben wir bis auf weiteres beim gemeinsamen Leistungsmessungs-Maßstab MIPS und, daraus abgeleitet, zur Messung des IT-Unternehmens-Nutzens beim Nutzen-Maßstab "MIPD" (Million Instructions per Day). Wie wir durch eine gezielte Auswertung unseres umfangreichen IT-Unternehmens-Datenmaterials vor kurzem Daten-basiert nachweisen können, sollte dieser Anteil zur Realisierung der preiswertesten Unternehmens-IT sogar wieder auf ca. 70% abgehoben werden! (www.ic-oc.de/ca)

Vergleichbar gravierend wie ein fehlender einheitlicher IT-Leistungsmaßstab ist immer noch die fehlende Unterscheidung zwischen der "Brutto-Leistungsfähigkeit der eingesetzten Computer" und der "Netto-Ressourcen-Realisierung zur IT-Unternehmens-Nutzen-Produktion"! Um die Thematik leichter verständlich zu machen, wollen wir einen Vergleich vorschlagen mit 2 allseits bekannten Brutto/Netto-Systemen, nämlich der Stromversorgung eines Hauses oder einer Wohnung und der Produktion von Transport-Nutzen mittels eines Automobils. In beiden Systemen wird die "Leistungsfähigkeit bzw. die Anschlussleistung" in KW angegeben, der "realisierte Nutzen" im Wohnungsbereich in KWh und beim Auto in Entfernungskilometern. Und nur dieser realisierte Nutzen ist bekanntlich zu bezahlen, direkt oder als Betriebskosten und Abschreibung.

Aus dem Strombeispiel lassen sich u.a. folgende Erkenntnisse ableiten: Der Unterschied zwischen Spitzenleistungsfähigkeit und durchschnittliche Last zur Nutzen-Produktion. Die Statistik für einen 4-Personen-Haushalt in Deutschland liefert folgende Daten: Verbrauch/Jahr ca. 4.000 KWh, üblicher Anschlusswert 16 KW: D.h. die durchschnittliche Auslastung beträgt 2,9%! Und jeder weiß natürlich, dass sich dieser Durchschnittswert durch Integration vieler Einzelverbrauchsabschnitte ergibt, in denen sehr unterschiedliche Verbrauchszustände auftreten können: Verbrauchssituationen unterschiedlicher Länge und mit unterschiedlich hohem Strombedarf und auch Zeitfenster mit unterschiedlich hohen Stromkosten.

Aus der Analogie mit einem Automobil lässt sich die zusätzlich Erkenntnis gewinnen, dass es auch ganz unterschiedliche Aufgabenstellungen geben kann, wie eben die Produktion von Transport-Nutzen im Stadtverkehr, auf der Landstraße und auf der Autobahn. Was bei diesem 2. Beispiel sofort überdeutlich wird ist die weitere Erkenntnis, dass für diese verschiedenen Transport-Aufgaben jeweils unterschiedlich konzipierte Transportfahrzeuge, d.h. Fahrzeuge mit unterschiedlicher Automobil-Architektur, die optimale Lösung darstellen.

Vergleichbare und noch weitere Einflussfaktoren sind bei der Umsetzung von Computer-Brutto-Leistungsfähigkeit in Unternehmens-Netto-Nutzen zu berücksichtigen. Dieses sind im Einzelnen: Die "Leistungsfähigkeit der eingesetzten Computer bei der speziellen Arbeitslast" und die "Anzahl der verwendeten Prozessoren bzw. Cores", die "Betriebszeit pro Tag", die "durchschnittliche Auslastung während der Betriebszeit", die "Wertigkeit der Arbeitslast" und die "Größe des System-Overheads."

Diese Einflussfaktoren unterscheiden sich bei den gegenwärtig zum Einsatz kommenden 3 Anwendungsfeldern, "Unternehmens-Anwendungen", "Abteilungs-Anwendungen" und "Benutzer-spezifische Anwendungen oder Anwendungs-Elemente" ganz fundamental und das Ergebnis überträgt sich auf die zum Einsatz kommenden Computer-Architekturen. Bei der MF-Architektur beträgt der Unterschied zwischen brutto und netto bei der üblichen 18 Stunden aktiven Betriebszeit eines Rechenzentrums pro Tag in der dt. Versicherungswirtschaft durchschnittlich ca. 25%. Auf der Unix-Plattform, eingesetzt für "Spezielle Anwendungen und Funktionen" beträgt der Unterschied auf 18 Betriebsstunden "normalisiert" ca. Faktor 21 oder 2.000%! Und für die x86-Plattform und ebenfalls für die Bearbeitung "Spezieller Anwendungen und Funktionen" beträgt der Faktor, wieder "normalisiert" auf 18 Betriebsstunden ca. Faktor 51 oder 5.000%!

Ein äußerst anschauliches Beispiel für den fundamentalen Unterschied von Computer-Leistungsfähigkeit und Nutzen-stiftender Computer-Arbeit liefert der von der Weltpresse 2011 ausführlich kommentierte Wettkampf zwischen einem "Computer-Ensemble" von IBM genannt "Watson" und den beiden besten US-Kandidaten in der Quizshow "Jeopardy", Brad Rutter und Ken Jennings, dem humanen Best-Practice-Benchmark mit Back-up, sozusagen. Für die Beschreibung der Leistungsfähigkeit der eingesetzten Computer-Systeme meint die Süddeutsche Zeitung die Messgröße "2.800 parallel geschaltete Prozessoren" als bestgeeignete Kennzahl verwenden zu sollen, im Wirtschaftsteil und von einem Computerfachmann verfasst übrigens. Die Computerfachpresse verwendete für die Beschreibung der Leistungsfähigkeit der Computer-Systeme unterschiedlich viele der folgenden Kenngrößen: 2.880 p7 Cores, 3,55 GHz Taktrate, 80 Billionen Rechenoperationen pro Sekunde und 16 TB Speicherkapazität: Botschaft "ein Supercomputer eben", wie die meisten Beiträge in den Überschriften behaupten. Wir ergänzen: Die Hardware dieses "Computer-Ensembles" hatte zu damaligen Marktpreisen einen Kaufpreis von etwa € 17 Millionen. Botschaft: Ein sündhaft teurer Supercomputer gegen 2 "kleine" Menschen?

Aber nur scheinbar, d.h. "brutto" nicht aber bei genauerem Hinsehen, d.h. "netto"! Denn netto betrachtet verbraucht dieser sogenannte Supercomputer nur etwa 3*100 Sekunden seiner Leistungsfähigkeit für die Beantwortung der angenommen 3*20 Fragen, bei 3 Spieldurchgängen, wie man bei IBM nachlesen kann. Die überragende Leistungsfähigkeit ist nur wegen der kurzen Antwortzeiten notwendig, die aus Wettbewerbsgründen wahrscheinlich bei nicht größer als ca. 5 Sekunden gelegen haben dürften. Seine "brutto" Arbeitskapazität beträgt aber bis zu 110,4 Millionen Sekunden während seiner üblichen Lebensdauer von ca. 3,5 Jahren. D.h., eine Sekunde Arbeitszeit kostet nur etwa € 0,16 und 3*100 Sekunden somit nur € 300 * € 0,16 = € 48,-- Hardware-Kosten! Und was geschieht normalerweise mit dem Rest der noch verfügbaren Arbeitskapazität? Die wird üblicherweise in einem RZ oder in der Cloud von den vielen Tausend anderen Benutzern zur Nutzen-Produktion eingesetzt. Die wahren Kosten dieser "Jeopardy-Anwendung" sind dagegen unerwähnt weil schwer plakativ ausdrückbar, bei der Programmierung entstanden: So nebenbei erfährt man von ca. 4 Jahren Entwicklungszeit und an anderer Stelle von etwa 20 Entwicklern. Die Software-Entwicklungskosten betragen somit etwa € 12 Millionen (20*4*150 Tsd), allerdings nur einmalig! Bei multiplem Verkauf, eine modifizierte Version für Krankenhäuser ist inzwischen in der Testphase und am Einsatz auch im Bankensektor, der Versicherungsbranche und bei Service-Anwendungen wird gearbeitet, verringert sich der Preis pro Kopie ganz wesentlich, da der "Gross Profit" bei der SW i.d.R. bei 85-90% liegt. Und der Vollständigkeit halber sei noch angemerkt, dass in der Praxis natürlich auch noch Produktions- und Wartungskosten in überschaubarer Größe auftreten.

Die Erkenntnis: Die einzig aussagefähigen IT-Kosten-Kennzahlen sind eine Auswahl repräsentativer "Netto-Kennzahlen", die in ihrer Gesamtheit das "gesamte netto Preis/Leistungsverhältnis, die net Total Price-Performance (nTPP) repräsentieren müssen!

Unternehmen, die diese Erkenntnisse nicht berücksichtigen, verschwenden i.d.R. erhebliche Teile ihres IT-Budgets durch "IT-In-Effizienz", da sie die Anwendungen nicht optimal auf die Plattformen verteilen können. Der einzige brauchbare Maßstab zur Bestimmung der effizientesten Verteilung der Anwendungen auf die 3 Anwendungs-Plattformen mit 4 Computer-Alternativen ist der Maßstabe "nTPP"(net Total-Price/Performance). Bei der Bestimmung der nTPP müssen selbstverständlich alle IT-Aufwendungen berücksichtigt werden, d.h. neben den HW- und SSW-Kosten auch die IT-Personal- und Betriebs-Kosten sowie die Kosten der eingekauften Anwendungs-SW, da sie outgesourcede Anwendungsentwickler darstellt. In der deutschen Versicherungsbranche haben die Best-Practice-Unternehmen ca. 40% niedrigere Kosten pro IT-Unternehmens-Nutzen produzierende Ressourcen-Einheit als die Unternehmen im Branchen-Durchschnitt und gegenüber den "Worst-Practice"-Unternehmen erreicht dieser Wert sogar ca. 65%.

Eine Zusammenstellung der nTPP-Kennzahlen von 16 Unternehmen der dt. Versicherungsbranche finden sie anonymisiert im Kapitel (Auswahl repräsentativer Kennzahlen).

Durch diesen Methodischen Lösungsansatz wird ein weiterer insbesondere für IT-Investitionen Erkenntnis-starker Vergleich verfügbar, nämlich der Vergleich der "Gesamtkosten einer algorithmisierbaren Aufgabe bei Realisierung mit Human-Ressourcen" mit den "Gesamtkosten bei Realisierung mit Computer-Ressourcen". Für die von uns als repräsentativ verwendete deutsche Versicherungsbranche lassen sich die folgenden Erkenntnisse gewinnen: Die Computer-Arbeit, gemessen z.B. in rMIPD, lässt sich relativ einfach in Mitarbeiter-Arbeits-Zeiteinheiten umrechnen: Z.B. entsprechen in der deutschen Versicherungsbranche im Jahre 2014 im Branchendurchschnitt 247 GIPD (Giga MF-Instructions per Day) dem Tages-Arbeits-Volumen eines Innendienst-Mitarbeiters im Branchendurchschnitt. Der ROI beträgt dabei gegenwärtig (10-12):1.

Mit diesen Erkenntnissen lassen sich darüber hinaus auch hoch interessante Antworten finden für den angeblichen zukünftigen Arbeitskräftemangel in Deutschland: Es gibt offensichtlich eine weitere, bisher nicht berücksichtigte, sehr mächtige Lösungsalternative, nämliche die verstärkte Verlagerung von Informationsbearbeitung von den Mitarbeitern auf Computer! Nach unserem gegenwärtigen Erkenntnisstand ließe sich damit in Deutschland die Arbeitslast von ca. 5-8 Millionen humanen Arbeitsplätzen auf Computer verlagern: D.h., dieses Potential an "virtuellen Arbeitskräften" ist sehr viel größer als die bisher diskutierten Alternativen "Abbau eines Teils der Arbeitslosigkeit", "Verlängerung der Lebensarbeitszeit", "Erhöhung des Anteils der Frauen bei den Erwerbstätigen" und schließlich der "These: Mehr Einwanderung Hochqualifizierter sei nötig, bis zu 500.000 pro Jahr werden bekanntlich ins Gespräch gebracht". Dabei sind die "virtuellen Arbeitskräfte durch IT" bei einem für zukünftige Anwendungen erzielbaren ROI von ca. 4:1 die volkswirtschaftlich eindeutig Wertvollsten und in Bezug auf die "Integrationsherausforderungen" am Einfachsten handbaren.

Um die Bedeutung der Entwicklung ausreichend geeigneter Maßstäbe zur Darstellung des IT-Unternehmens-Nutzens als Grundvoraussetzung für einen erfolgreichen Lösungsansatz mit Realisierungspotential zu verdeutlichen, möchten wir kurz den Lösungsversuch eines der laut IT-Fachliteratur angeblich bedeutendsten Wirtschaftsinformatikers auf diesem Sachgebiet, Herrn Erik Brynjolfsson, Professor am MIT, Sektion Sloan School of Management, vorstellen. Um den Nutzen des IT-Einsatzes in den Unternehmen zu messen, hat Herr Brynjolfsson die folgende Korrelation vorgenommen: Er setzt ins Verhältnis die "IT hardware-cost per worker" auf der Abszisse mit der "total factor-productivity" auf der Ordinate und verwendet dabei die Daten von 1.167 Unternehmen aller Branchen. Als Ergebnis erhält er eine "weit streuende Punkte-Wolke" durch die er eine "leicht ansteigende Gerade!" offensichtlich nach Gefühl gezogen hat. Quelle: "The Productivity Gap", Erik Brynjolfsson, 2003, Issue 21. Unsere Erkenntnis: Wer derart stark "verschmutze" Maßstäbe verwendet, kann theoretisch beweisbar, keine eindeutigen und damit realisierbaren Erkenntnisse geliefert bekommen. Erstaunlich ist an dem Beispiel v.a., dass Herr Brynjolfsson, diese Erkenntnisse nicht schon vorab durch eine Bestimmung der notwendigen Messgenauigkeit der Maßstäbe erkannt hat und dass viele Wirtschaftsinformatik-Professoren diese Ausarbeitung immer noch als State-of-the-art-Erkenntnis propagieren. Bemerkenswert erscheint uns weiterhin daraufhin zuweisen, dass sich Herr Brynjolfsson inzwischen anderen, einfacheren(?) Themen zugewandt zu haben scheint.

Kalibrierung mittels der Erkenntnisse der Kollektiven Intelligenz

Unsere Lösungstheorie liefert des Weiteren eindeutige Hinweise über eine erfolgreiche Vorgehensweise zur Gewinnung der IT-Unternehmens-Nutzen-Erkenntnisse als Basis zur Realisierung für die einzelnen Unternehmen.

Wie in den bisherigen Ausführungen bereits ausführlich erläutert, lässt sich der Einfluss des Einsatzes von IT-Ressourcen auf die Human-Ressourcen für die algorithmisierbare Informationsverarbeitung in einem Unternehmen gegenwärtig zwar nicht "unmittelbar", d.h. für ein singuläres Unternehmen, wohl aber "mittelbar", d.h. durch "Benchmarking mit vergleichbaren Unternehmen" bestimmen. Die Voraussetzungen für die Gewinnung möglichst hochwertiger Erkenntnisse definieren sich bei dieser Konstellation quasi von selbst. Zusammengefasst kann man formulieren: Alle am Benchmarking teilnehmenden Unternehmen sollten möglichst gleichartig und gleichwertig sein, damit die erzielten Erkenntnisse möglichst von allen unmittelbar verwendet werden können. Dies ist die Zielsetzung aus der Sicht der Aufwandsminimierung. Aus der Sicht der Erkenntnis-Maximierung sollten aber möglichst viele Unternehmen in das Benchmarking-Sample aufgenommen werden, damit möglichst alle wertvollen Erkenntnisse in der Analyse enthalten sind, insbesondere die "Best-Practice"-Erkenntnisse, die per definitionem eine "elitäre Größe" darstellen, da sie das beste bisher erreichte Ergebnis repräsentieren. Dies ist also erneut eine konfrontale Situation, für die ein bestmöglicher Kompromiss gefunden werden muss.

Für die Auswahl der am Benchmarking zu beteiligenden Unternehmen ergeben sich Kriterien insbesondere aus der Definition der Ordinate, die die algorithmisierbare Informationsverarbeitung abbildet. Die IT-Ressourcen abbildende Abszisse ist dagegen sehr viel weniger von Unternehmens-individuellen Einflüssen geprägt.

Bestimmung möglichst gleichartiger Unternehmen

Wir wollen deshalb mit der Auswahl des Benchmarking-Samples anhand der Kriterien für die Ordinate beginnen. Das Kriterium "möglichst gleichartig und gleichwertig" erfüllen bekanntlich v.a. die Unternehmen einer Branche, weil die Definition einer Branche genau diese Zielsetzung hat. Aus dem Blickfeld der IT teilt man die gesamte Wirtschaft in der Regel in 6 Branchen ein, ergänzt durch die Staatlichen Einrichtungen "Wissenschaft" und "Verwaltung" als 7. und 8. Bereich. Bei den Branchen gibt es wiederum relativ homogene Branchen, wie die "Versicherungs-Branche" und mit Einschränkungen auch die "Banken-Branche" und extrem heterogene und große Branchen, wie insbesondere die "Fertigungs-Industrie". Die "Grundstoff-Industrie", "Handel" und "Dienstleistungen" vervollständigen diese Unterteilung.

Aus dieser Aufteilung ergibt sich praktisch von selbst die Einschätzung, dass die Versicherungsbranche für diesen Methodischen Lösungsansatz das bestgeeignete Testfeld bieten dürfte. Schon eine kurze Analyse bestätigt diesen Eindruck: Die Branche bestand im Jahre 2013 aus ca. 101 Versicherungsunternehmen mit mehr als 100 Beschäftigten unterteilt in ca. 225 Gesellschaften. Die deutsche Versicherungsbranche beschäftigte 212.700 Arbeitnehmer in der Unterteilung 160.300 Innendienst-Mitarbeiter, 39.700 Außendienst-Angestellte und 12.700 Auszubildende. Außerdem gab es 165.700 gebundene Versicherungsvermittler und 246.500 selbständige Versicherungs-Vermittler/-Berater. Anmerkung: Die Beschränkung auf Versicherungsunternehmen mit mehr als 100 Beschäftigten ist bei unserem Lösungsansatz sinnvoll/notwendig, um "Economy-of-Scale-Effekte" möglichst gering zu halten.

Nach unserer langjährigen Erfahrung sollte ein Erkenntnis-reiches Sample aus mindestens 2 Dutzend Unternehmen bestehen, wobei die Zielsetzung "alle geeigneten Unternehmen" natürlich die optimale, erstrebenswerte Zielsetzung darstellt. Unsere Sample der deutschen Versicherungsbranche umfassen jeweils i.d.R. ca. 90-95% der Beschäftigten der dt. VB. Die dt. VB ist mit ca. 101 potentiellen Unternehmen auch in dieser Beziehung das bestgeeignete Testfeld. Angemerkt sei an dieser Stelle, dass die Idee der Erkenntnisgewinnung mittels Situationsvergleichen von Unternehmen insbesondere in der dt. Versicherungsbranche eine Jahrzehnte lange "Tradition" hat: In mehreren Ballungsgebieten Deutschlands haben sich die IT-Manager von i.d.R. einer Handvoll VU unregelmäßig zum Gedankenaustausch zusammengefunden, um Unternehmens-Nutzen-steigernde IT-Lösungsideen auszutauschen. Da der dabei verwendete "Methodische Ansatz" aber eher vom Typ "unverbindliches Plaudergespräch" ist, waren die Ergebnisse bisher recht überschaubar.

Um der Forderung nach algorithmisierbarer Informationsverarbeitung bestmöglich gerecht zu werden, muss man in der deutschen Versicherungsbranche die Mitarbeiter in die folgenden 4 Haupt-Aufgaben-Bereiche unterteilen: Innendienst-MA, angestellte Außendienst-MA, Auszubildende und abhängig Beschäftigte im Außendienst. Im Fokus der IT-Unternehmens-Nutzen-Steigerung stehen dabei die Innendienst-MA, die 75,4% der angestellten MA repräsentieren und im Branchendurchschnitt über 90% der IT-Ressourcen "verbrauchen". Auch bei der Bildung von Gruppen mit möglichst gleichartiger algorithmisierbarer Informationsverarbeitung" ist die Versicherungsbranche am besten geeignet. Denn in allen anderen Branchen, mit Ausnahme der Bankenbranche, muss man die Mitarbeiter zunächst unterteilen in "Angestellte" und "Arbeiter", im Angelsächsischen genauer definiert als "White-Collar-" und "Blue-Collar-Beschäftigte". Die Angestellten sind sodann weiter zu unterteilen in "Stabs- und Verwaltungs-MA", "Außendienst-MA", "Auszubildende" und ev. noch in "MA in Forschung und Entwicklung". Einer weiteren Differenzierung, die aber unbedingt deduktiv vorzunehmen ist, steht natürlich nichts im Wege außer der Aufwand und die Verfügbarkeit des benötigten Datenmaterials.

Aus der Forderung "möglichst gleichartig und gleichwertig" im Bereich "algorithmisierbare Informationsverarbeitung" zu sein ergibt sich für die Versicherungsbranche doch noch ein "Wermutstropfen", denn die Arbeitslast in der dt. Versicherungsbranche (VB) besteht, genauer betrachtet, aus 5 verschiedenen Arbeitslast-Typen, definiert v.a. durch die 5 Versicherungszweige (VZ) "Lebensversicherung (LV)", "Schaden/Unfall-Versicherung (SU)", "Krankenversicherung", "Rechtschutzversicherung" und "Rückversicherung". Verwendet man die Brutto-Beitrags-Einnahmen (BBE) als repräsentativen Arbeitslast-Indikator, wie in der VB allgemein üblich und nach unserer Erfahrung auch bestgeeignet und setzt die Arbeitslast pro BBE-Einheit in der LV gleich 1, dann war 2013 die AL bei SU Faktor 3,2, bei Kranken Faktor 1,83, bei Rechtschutz Faktor 3,22 und bei Rück Faktor 0,459. Schlussfolgerung: Die Korrelation "Human-Ressourcen für die algorithmisierbare Informationsverarbeitung" vs "IT-Ressourcen" führt nur bei der Umsetzung für die einzelnen VZ zu einer Genauigkeit der Erkenntnisse, die als Basis für die realisierbaren IT-Nutzen-Erkenntnisse notwendig ist.

Um die Genauigkeit der Erkenntnisse pro Versicherungszweig weiter zu steigern, haben wir mit fortschreitender Erfahrung die individuellen Abweichungen der einzelnen VU vom Branchendurchschnitt immer besser berücksichtigt, wobei wir v.a. auch die Hinweise unserer Klienten und Kollaborations-Partner gerne eingearbeitet haben. Beispielweise berücksichtigen wir im Versicherungszweig Leben die Abweichungen in den Einflussgrößen "Größe der Verträge", "Beitrags-freier Bestand", "Bewegung des Bestandes", "Storno-Quote", "Anteil Kollektiv-Versicherungen", "Anteil Rentenversicherungen" und "Anteil Einmal-Beiträge", denn eine Abweichung dieser Einflussgrößen vom Branchendurchschnitt führt auch zu einer, wenn auch meistens nur geringen Änderung der Arbeitslast. Das Produkt dieser Abweichungen fassen wir deshalb in einem "Normalisierungs-Faktor" zusammen. Diese Erkenntnis kann und sollte auch auf Lösungsansätze in anderen Branchen sinngemäß übertragen werden.

Bestimmung möglichst vergleichbarer IT-Ressourcen

Die Bestimmung der in einem Unternehmen eingesetzten gesamten IT-Ressourcen, die sich aus Systemen von bis zu 4 verschiedenen Computer-Architekturen zusammensetzen können, in einem einheitlichen Maßstab als Abszisse ist insbesondere seit der Jahrhundertwende zu einer immer größeren Herausforderung geworden. Hilfreich für die Vorgehensweise erscheint uns dabei ein kurzer Rückblick auf die Entwicklung der in den Unternehmen eingesetzten IT-Ressourcen.

Bis Ende der 70'er Jahre des vergangenen Jahrhunderts gab es für die Informationsverarbeitung bekanntlich nur Mainframes, Prozessrechner und wissenschaftliche Hochleistungsrechner. Die Mainframes stammten von mindestens 7 Herstellern und waren i.d.R. nur auf Mietbasis zu haben. Die Leistungsfähigkeit der Systeme musste deshalb von den Herstellern offengelegt werden und der IT-Ressourcen-Einsatz in einem Unternehmen war somit eindeutig festgelegt. Herausfordernd war nur die Umrechnung der Leistungsangaben der verschiedenen Hersteller, was aber eher selten notwendig war, da Herstellerwechsel wegen der Umstellungskosten kaum vorgekommen sind. Angemerkt sei noch, dass zu dieser Zeit die System-SW kostenlos, d.h. im HW-Mietpreis enthalten war.

Mit dem offiziellen Erscheinen des PC 1981 hat sich daran zunächst nichts geändert, denn die PCs waren anfangs kaum mehr als intelligente Terminals. Ihr Beitrag zur Produktion des IT-Unternehmens-Nutzens war deshalb vernachlässigbar.

Grundsätzlich verändert hat sich die Situation erst seit Beginn der 00'er Jahre: Neben dem Verschwinden fast aller Mainframe-Hersteller bis auf v.a. IBM und unbedeutend noch Siemens und in Japan Fujitsu wurden die Prozess-Rechner zu leistungsstarken Unix-(Linux)Systemen weiterentwickelt, die auch für kommerzielle Anwendungen einsetzbar wurden. Zusätzlich waren die x86-Hersteller bemüht, in das üblicherweise Margen-starke Groß-Computer-Segment vorzudringen. Und auch das Verarbeitungs-Segment auf PC-Basis wurde durch das "Client/Server-Konzept" leistungsfähiger. Erst durch das Angebot von vollwertigen Alternativen zur Realisierung der in einem Unternehmen benötigten Computer-Ressourcen stellt sich die Frage nach der Kosten-günstigsten Verteilung auf die verschiedenen Computer-Plattformen. Zur Beantwortung dieser Fragestellung haben wir, wie bereits erwähnt und wie noch ausführlich dargestellt wird, die Messgröße TPP entwickelt.

Wenn man diese Evolution aufmerksam begleitet hat und/oder sie systematisch analysiert, dann kann man ausreichende Erkenntnisse gewinnen, um die Ressourcenbeiträge der verschiedenen Computer-Architekturen mit ausreichender Genauigkeit zu den "gesamten IT-Unternehmens-Ressourcen" zusammenzufügen. Als wichtiges Element der Qualitätssicherung können wir dabei auf die Ergebnisse unseres 2-dimensionalen Lösungsansatzes zurückgreifen, der größere Ungenauigkeiten oder Fehleinschätzungen mit großer Deutlichkeit anzeigen würde! Die Vorgehensweise ist bereits im Kapitel (Methodischer Ansatz zur Umsetzung - Auslegung der Abszisse) beschrieben

Vervollständigt werden sollte die Verbesserung des IT-Ressourcen-Maßstabes durch die mit diesem Methodischen Lösungsansatz ebenfalls gewinnbare Erkenntnis über die "optimale IT-Umsetzungs-Effizienz".

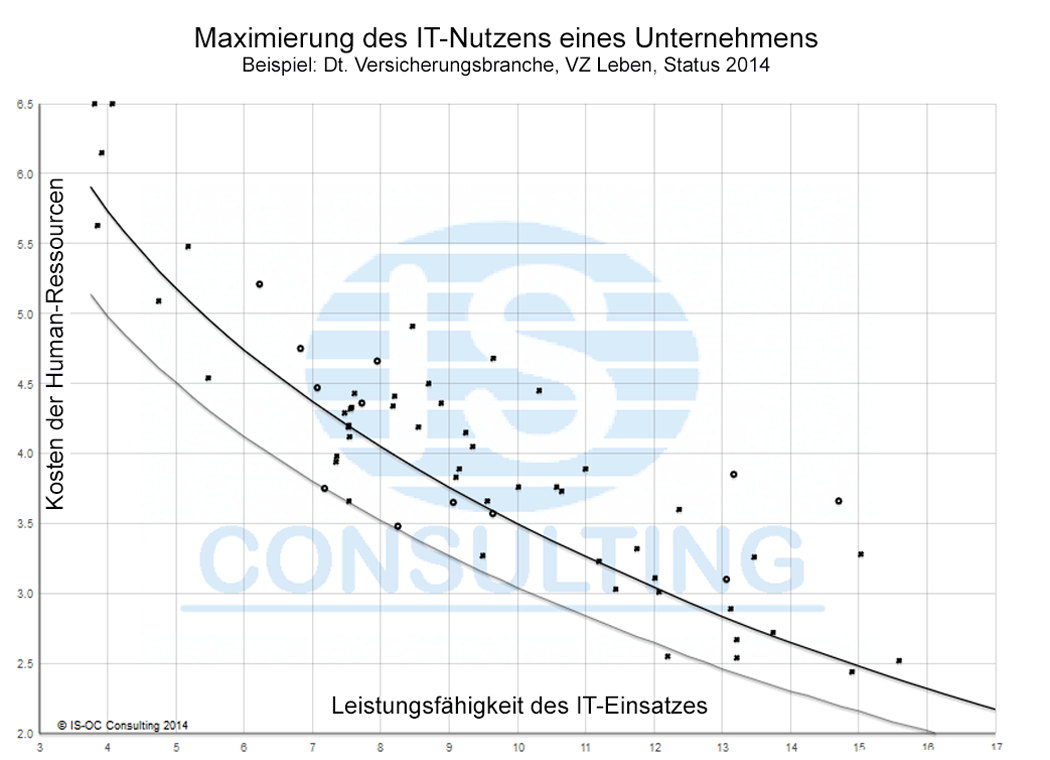

Beispiel: Korrelation Human-Ressourcen vs IT-Ressourcen im VZ Leben der dt. Versicherungbranche

Nachdem wir nunmehr die Koordinaten für die einzelnen VU bestimmt haben, lassen sich diese in ein Diagramm übertragen. Das Ergebnis für den Versicherungszweig Leben der deutschen Versicherungsbranche ist nachfolgend dargestellt.

mit der „IT-Unterstützung pro Mitarbeiter“ im Versicherungszweig Leben

Erkenntnisse aus der Korrelation Human-Ressourcen vs IT-Ressourcen

Die Korrelation "Human-Ressourcen vs IT-Ressourcen" für die Innendienstmitarbeiter des Versicherungszweigs Leben der deutschen Versicherungsbranche mit dem Status 2014 signalisiert einen eindeutigen Zusammenhang zwischen dem IT-Ressourcen-Einsat bei den ID-MAn, aufgetragen auf der Abszisse und dem Human-Ressourcen-Bedarf pro Arbeitseinheit, dargestellt auf der Ordinate. Dabei haben wir die Maßstäbe den in der Versicherungsbranche üblichen Kennzahlen angepasst.

Die Streubreite der Einzelwerte hat verschiedene "natürliche" Ursachen, die zum Einen in Ineffizienzen im Geschäftsmodell der einzelnen Firmen und zum Anderen in Ineffizienzen beim Einsatzes der IT-Ressourcen zur IT-Nutzen-Produktion zu finden sind. Bei Ineffizienzen im Geschäftsmodell handelt es sich in der Versicherungsbranche v.a. um nicht optimale Organisationen, insbesondere im Bereich Zentralisation/Dezentralisation und um eine verbesserungsfähige Unternehmenskultur. Bei den IT-Ressourcen gibt es noch Ineffizienzen insbesondere im Bereich IT-Prozess-Unterstützung oder "Blindleistung auf den Systemen", das sind IT-Ressourcen, die keinen Unternehmens-Nutzen produzieren. Auch dieses Phänomen lässt sich mit diesem MLA beseitigen. Einzelheiten hierzu sind im Kapitel (Geringste IT-Unternehmens-Kosten - Beseitigung der Blindleistung) zu finden.

Das Ergebnis der Korrelation ist so eindeutig, dass es sich zu einer Kurve komprimieren lässt, die den Branchendurchschnitt, hier für den VZ Leben, beschreibt. Damit ist die Basis gelegt für Daten-basierte ökonomische Erkenntnis-Prognosen!

Diese Durchschnittskurve sollte, nach unserer Erfahrung aber nicht "formalistisch", z.B. mit der Methode des kleinsten Fehlerabstandsquadrates produziert werden, denn die Positionen der einzelnen Unternehmen repräsentieren oftmals eine sehr unterschiedliche Erkenntnissubstanz, die unbedingt zu berücksichtigen ist.

Diese Korrelation "Human-Ressourcen vs IT-Ressourcen" für die ID-MA des Versicherungszweigs Leben der deutschen Versicherungsbranche umfasst 72 Unternehmen mit 94% der Brutto-Beitrags-Einnahmen in Deutschland. Damit dürften die Zielsetzungen für das Sample, nämlich "mehr als 2 Dutzend Unternehmen", "möglichst alle bedeutenden Unternehmen" und damit "möglichst auch die Best-Benefit/Practice-Unternehmen" erfasst zu haben, ausreichend erfüllt sein.

Dieses Diagramm repräsentiert offensichtlich die Summe der "kollektiven Intelligenz der im VZ Leben Beschäftigten und der für den VZ Leben eingesetzten IT-Anwendungsentwickler in Deutschland". Damit ist die Basis gelegt, auf der sich einzelne Unternehmen betriebswirtschaftlich fundiert mit anderen Unternehmen vergleichen können, um dadurch IT-Unternehmens-Nutzen-Potentiale für sich zu erschließen. Schon auf diesem Niveau der Erkenntnisgewinnung lässt sich vermuten, dass Vergleiche mit den seit etwa 1997 sogenannten "Best-Practice (BP)"-Unternehmen besonders wertvoll sein dürften. Anmerkung: SAP war eines der ersten Unternehmen, das diese Bezeichnung verwendet hat, allerdings mit einer anderen Semantik! Näheres an geeigneter Stelle. Von uns wurde diese Erkenntnisgröße schon 1985 unter Bezeichnung "Best-of-Breed" eingeführt.

Für andere Branchen sind vergleichbare Sample zu entwickeln, was nach unserem Erkenntnisstand möglich sein sollte.

IT-Unternehmens-Nutzen-Potential-Bestimmung mittels "Rating" und "Business Case" relativ zu "Best Benefit/Practice"

Bevor wir auf der Durchschnittskurve basierende Auswertungen vornehmen, müssen wir auf eine weitere grundsätzliche und wichtige Erkenntnis aufmerksam machen, die wie folgt formuliert werden kann:

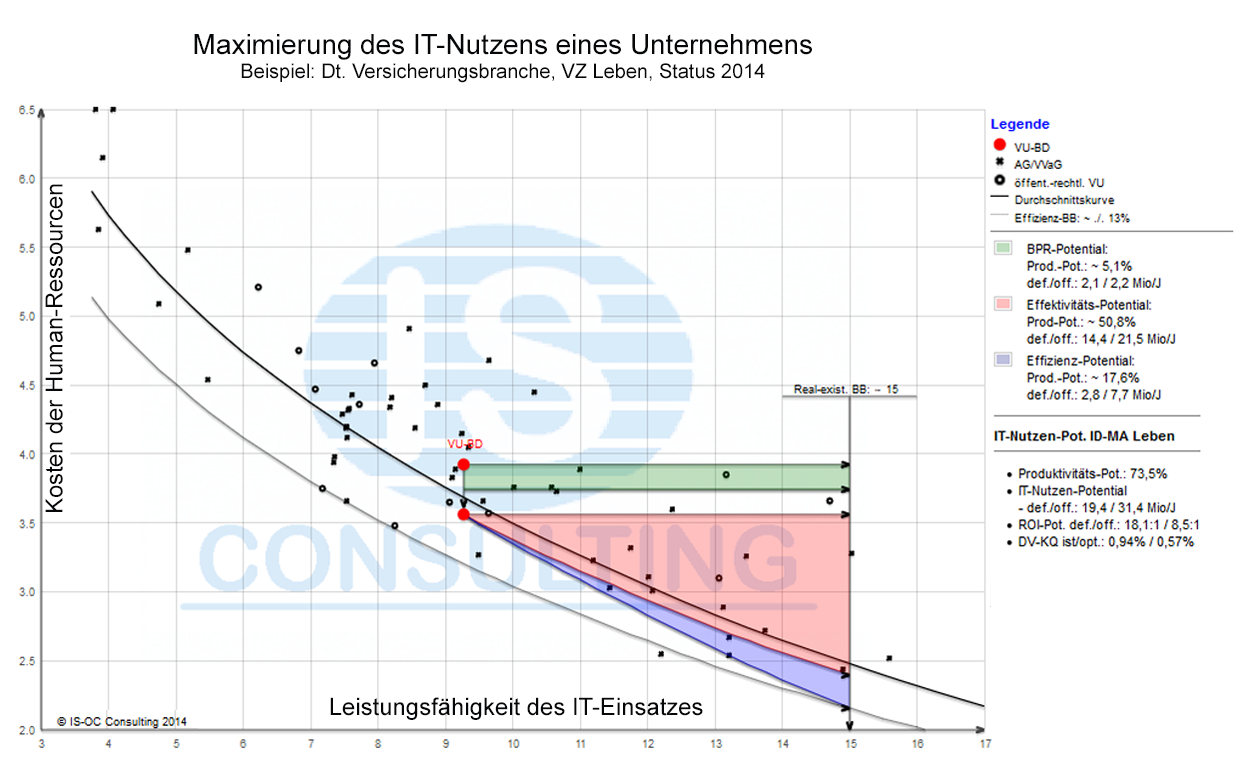

Damit können nunmehr folgende IT-Unternehmens-Nutzen-Potential-Erkenntnisse für den VZ Leben gewonnen werden:

- Die Koordinaten der "real-existierenden Effektivitäts-Best-Benefit/Practice im VZ-Leben" werden definiert durch die Durchschnittskurve auf den Niveau der reBP, z.B. 2014 (€ 15.500, 2,40%)

- Die Koordinaten der "real-existierenden Effektivitäts-und Effizienz-Best-Benefit/Practice im VZ-Leben" werden definiert durch das Niveau der Umsetzungs-Effizienz-Kurve auf dem Niveau reBP, z.B. 2014 (€ 15.500; 2,09%)

IT-Unternehmens-Nutzen-Potential-Bestimmung relativ zu "Best-Benefit/Practice"

Nachdem wir des Weiteren die IT-Effektivitäts- und die IT-Effizienz-Best-Benefit/Practice-Zielgrößen festgelegt haben, können wir nunmehr das IT-Unternehmens-Nutzen-Potential jedes einzelnen Unternehmens relativ zu BP in betriebswirtschaftlichen Messgrößen und unterteilt in 3 Nutzen-Potential-Segmente bestimmen.

im Versicherungszweig Leben

Die Führungserkenntnisse "Rating" und "Business Case"

Die Schlüsselfrage am Beginn aller strategischen IT-Aktivitäten lautet aus Management-Sicht bekanntlich: "Gibt es überhaupt Handlungsbedarf?" Können neue IT-Unternehmens-Nutzen/Kosten-Potenziale erschlossen werden? Ergeben sich ev. auch Wettbewerbsvorteile? D.h., es sollte zunächst der Versuch eines "Ratings" unternommen, absolut oder relativ zu den Haupt-Mitbewerbern oder zu den Besten der Branche, gefolgt durch eine "Bewertung" i.d.R. mittels "Business Case" bzw. betriebswirtschaftlicher Modellrechnung zur Einordnung in den Entscheidungsprozess mit allen anderen zur Realisierung anstehenden Aufgaben eines Unternehmens. Deshalb ist es von elementarer Bedeutung, dass endlich auch für die "IT in ihrer Gesamtheit" ihr "betriebswirtschaftlicher Unternehmenswert oder Wertbeitrag" dargestellt werden kann. Auf der Basis der durch unseren MLA verfügbar werden Erkenntnisse ist die Übersetzung in die Spielregeln der Betriebswirtschaft dann nur noch "Handarbeit".

Bei der Erstellung einer "Betriebswirtschaftlichen Modellrechnung" sollte wie folgt vorgegangen werden:

- Ausgangs-Position ist die "auf Branchendurchschnitt normalisierte Unternehmensposition".

- Die Ziel-Positionen sind beim ersten Ansatz die "Positionen real-existierende Effektivitäts-und Effizienz-Best-Benefit/Practice".

- Da das ev. vorhandene IT-Unternehmens-Nutzen-Potential aus 3 völlig unterschiedlichen Potential-Segmenten besteht, nämlich dem "IT-Effektivitäts-Potential", dem "IT-Effizienz-Potential" und dem "Business-Process-Reengineering-Potential", sollte es insbesondere mit Blick auf die unterschiedlichen Vorgehensweisen bei der Realisierung bei der Potential-Darstellung schon in diese 3 Teil-Potential-Segmente unterteilt werden.

IT-Effektivitäts-Potential und IT-Effizienz-Potential

Zunächst ist es erfahrungsgemäß unumgänglich, die 3 IT-Potential-Segmente kurz zu definieren, da die semantischen Missverständnisse über 2 dieser 3 elementaren IT-Größen die IT-Entscheidungen seit mindestens 40 Jahren sehr häufig in eine nicht-optimale Richtung gelenkt haben. Insbesondere die Semantik der beiden Größen "IT-Effektivität" und "IT-Effizienz" wird häufig missverstanden und selbst in Lexika, wie dem Brockhaus, als quasi eng verwandt dargestellt, was aber völlig unzutreffend ist. Da trifft es beispielweise der Volksmund mit der folgenden Definition sehr viel besser:

- Effektivität heißt, die richtigen Dinge tun dagegen

- Effizienz heißt, die Dinge richtig tun.

Auf die Realisierung der IT in einem Unternehmen übertragen heißt das:

- Das IT-Effektivitäts-Potential gewinnt man durch Ausschöpfen des IT-Nutzen-Potentials der State-of-the-art-IT-Funktionen bis zum Optimum, ersatzweise bis BP.

- Das IT-Effizienz-Potential dagegen gewinnt man, wenn man die vorhandene oder geplante IT-Funktionalität optimal zum Einsatz bringt.

Business-Process-Reengineering-Potential

Bei der Realisierung neuer Anwendungen müssen fast immer auch die neu-unterstützten Geschäftsprozesse angemessen weiterentwickelt werden, damit die neuen Anwendungen ihre volle Leistungsfähigkeit entfalten können. Des Öfteren ist es auch notwendig, die Unternehmens-Organisation der sich weiter entwickelten optimalen Organisationsform anzupassen. Bei Unternehmen, die oberhalb der Umsetzungs-Effizienz-Kurve liegen, ist dies offensichtlich i.d.R. bisher nicht geschehen. Deshalb muss zunächst abgeschätzt werden, wie groß der Anteil an "organisatorischer Ineffizienz" ist, möglicherweise strategisch begründet, und wie groß der Anteil an "IT-Prozess-Unterstützungs-Ineffizienz" sein dürfte. Falls es dafür in einem Unternehmen bisher keine ausreichenden Erkenntnisse gibt, hat sich erfahrungsgemäß ein Einstieg mit der Annahme einer 50:50-Situation sehr gut bewährt.

Führungserkenntnis "Rating"

Der offensichtliche Vorteil eines Methodischen Lösungsansatzes in deduktiver Struktur ist die System-immanente Fähigkeit des "Ratings" einer Situation. Bei unserem MLA lässt sich oft schon durch Vergleich der IT-Unternehmens-Potential-IST-Position mit der Best-Benefit/Practice-Position visuell erkennen, ob eine weitere Beschäftigung mit der Aufgabenstellung ökonomisch sinnvoll sein dürfte. Ansonsten genügt eine erste "Überschlagsrechnung", um sich endgültig Klarheit zu verschaffen.

Führungserkenntnisse mittels "Business Case"

Hat das "Rating" zu dem Ergebnis geführt, dass ein wesentliches IT-Unternehmens-Nutzen-Potential vorliegt, stellt unser MLA die folgende Vorgehensweise zu dessen genauer betriebswirtschaftlichen Bestimmung zur Verfügung:

Als Erstes ist die IST-Position als Ausgangs-Position für den Business Case einer genaueren Untersuchung zu unterziehen mit der Zielsetzung, die Ineffizienz der Unternehmens-Organisation und der IT-Prozess-Unterstützung zu bestimmen. Wenn dafür keine ausreichenden Erkenntnisse vorhanden sind, sollte erfahrungsgemäß mit der Annahme 50:50 begonnen werden. Damit ist die "modifizierte IST-Position als Ausgangs-Position" für die Berechnung des IT-Effektivitäts-Potentials und des IT-Effizienz-Potentials festgelegt. Eine Nachbesserung kann jederzeit erfolgen.

- Das IT-Effektivitäts-Potential ergibt sich aus der Differenz der Ordinatenwerte bei Parallel-Verschiebung der modifizierten IST-Position zur Branchendurchschnittskurve bis auf das Niveau Best-Benefit/Practice.

- Das IT-Effizienz-Potential ergibt sich aus dem verbleibenden Delta gebildet durch die IT-Effektivitäts-Ordinate auf BP-Niveau und dem Ordinaten-Punkt von Effizienz-Best-Benefit/Practice.

- Das Business-Process-Reengineering-Potential hat i.d.R. die Größe von etwa 50% der Differenz der Ordinatenwerte IST-Position und mod. IST-Position.

- Produktivitäts-Fortschritt in (%)

- Anzahl betroffene Beschäftigte

- IT-Nutzen-Potential in Arbeitsplatzkosten-Einsparungen in (Mio €)

- Zusätzlich bearbeitbare Arbeitslast bei gleichbleibenden Arbeitsplatzkosten (Mio €)

- Profitabilität in bei der Realisierung in ROI

- Zusätzlicher IT-Aufwand in (Mio €)

- Kennzahlen, wie dem "EDV-Kostensatz" in der dt. VB

Die Zielgröße "Best-Benefit/Practice"

Um es noch einmal unmissverständlich zum Ausdruck zu bringen: Die Zielgröße "Best-Practice" ist nur eine Ersatz-Zielgröße anstelle der "Optimum-Zielsetzung State-of-the-art". Dennoch stellt sie eine ganz wesentliche Erkenntnis-Verbesserung gegenüber der IST-Situation dar. In der deutschen Versicherungsbranche z.B. würde eine Verbesserung des durchschnittlichen Versicherungsunternehmens auf das Niveau der "real-existierenden BP" zu einer Verbesserung der Produktivität um bis zu 75% führen.

Die Erkenntnisse des Niveaus Best-Benefit/Practice gibt es erfreulicherweise auf mehreren Realisierungs-Niveaus, nämlich in der Version

- "BP real-existierender Unternehmen" (reBP), die das unterste Realisierungs-Niveau definiert.

Sodann in den Versionen - "Best-Benefit/Practice aus Einzel-Optimierung" (BPeO). Diese Zielgröße gewinnt man, wenn man die BP-Lösungen der einzelnen Geschäftsprozesse miteinander kombiniert. Das ist i.d.R. zulässig, da die Verbesserung der einzelnen GP unabhängig voneinander möglich ist. Und schließlich auf dem Niveau

- "BP westliche Welt" (BPwW), natürlich wieder in beiden Alternativen.

IT-Unternehmens-Nutzen/Kosten-Rechner

Da dieser Methodische Lösungsansatz ausschließlich aus Daten und Algorithmen besteht, produzieren wir die Erkenntnisse durch Programmsysteme, die auf unseren Computern und auf den Computern eines "Cloud-Computer"-Anbieters ausgeführt werden. Zur eingehenderen Überprüfung der IT-Unternehmens-Nutzen-Potentiale und der IT-Unternehmens-Kosten-Einspar-Potentiale stellen wir unseren Interessenten unseren "IT-Unternehmens-Nutzen/Kosten-Rechner" kostenlos im Internet zur Verfügung. Vor dem Einsatz dieses bisher einmaligen Erkenntnis-Gewinnungs-Tools sollte der Anwender aber die folgenden Zusammenhänge verstehen.

Der zur Verfügung gestellte IT-Unternehmens-Nutzen/Kosten-Rechner ist von seinem Wesen her ein Expertensystem. Wesentliche Fähigkeiten eines Experten bestehen bekanntlich nicht nur darin, durch Verknüpfung von Daten und Informationen mittels Algorithmen Wissen und Know-how zu erzeugen, sondern auch in seiner Fähigkeit, unpräzises und unvollständiges Datenmaterial zu erkennen, für die Lösungsfindung absolut notwendige Informationen nachzufordern und mit unpräzisem und unvollständigem Datenmaterial Ergebnisse mit ausreichender Qualität erarbeiten zu können:

Die größte Herausforderung bei der Organisation eines auf einem Computer ablauffähigen Expertensystems besteht in der Regel darin, diesem diese Fähigkeiten in ausreichendem Umfang "beizubringen". Dafür haben wir Handlungsanweisungen eingebaut, die dafür sorgen, dass die Ergebnisse ein ausreichend hohes Qualitäts-Niveau aufweisen und dem Expertensystem eine angemessene Robustheit "anerzogen", damit es auch bei unvollständigem Datenmaterial funktionsfähig bleibt und durch Missverständnisse induzierte falsche Daten erkennt und mittels Korrekturmaßnahmen berichtigen kann. Denn das schlimmste aller möglichen Ergebnisse eines Expertensystems, wie dieses IT-Unternehmens-Nutzen/Kosten-Rechners, heißt Garbage out! Diese Situation werden wir deshalb mit allen uns zur Verfügung stehenden Mitteln zu verhindern suchen.

Dabei entsteht "Garbage out" zugegebenermaßen natürlich nicht nur durch Garbage in, wie von Computer-Fachleuten oft so locker wie schön rednerisch formuliert, sondern selbstverständlich auch durch Garbage-Processing, durch fehlerhafte Verarbeitung der eingegeben Daten und Informationen. Und diese fehlerhafte Verarbeitung wiederum kann v. a. 2 nicht triviale Ursachen haben, nämlich die Verwendung der vorhandenen Algorithmen in i. d. R. selten auftretenden Konstellationen, in denen sie aber keine Gültigkeit mehr besitzen oder aber ihr Einsatz in Verarbeitungskonstellationen, für die das Expertensystem (noch) nicht ausgelegt ist.

Um "Garbage out" zu vermeiden, haben wir deshalb umfangreiche Plausibilitäts-Prüfungen in das "Expertensystem IT-Unternehmens-Nutzen/Kosten-Rechner" eingebaut, sowohl für die Daten- und Informations-Eingabe als auch für die ermittelten Ergebnisse. Dabei kann es möglicherweise vorkommen, dass auch sehr ungewöhnliche Informations-Konstellationen bei der Daten- und Informationseingabe oder von den Branchen-Durchschnittswerten zu stark abweichende Ergebnisse den Plausibilitäts-Prüfungen "zum Opfer fallen". In diesen Fällen möchten wir die Benutzer um Verständnis bitten und sie ersuchen, per eMail bei IS-O Consulting Unterstützung durch einen "humanen Experten" anzufordern.Erster holistisch-deduktiver IT-Unternehmens-Nutzen/Kosten-Lösungsansatz

Was sind die fundamentalen Vorteile eines holistisch-deduktiven Lösungsansatzes? Und, falls diese Vorteile tatsächlich fundamental sein sollten, warum gibt es diesen Lösungsansatz in dieser über 60 Jahre alten Branche nicht schon seit langem?

Die Antwort lässt sich unschwer finden, wenn man die Entwicklungsgeschichte der IT-Branche kurz nachzeichnet. Eine fundamentale Schwachstelle der Informationsverarbeitung ist nach unserer Einschätzung ihre seit Anbeginn US-angelsächsische, pragmatische Prägung. Die typische Vorgehensweise bei der Realisierung neuer IT-Produkte oder IT-Konzepte war und ist bekanntlich immer noch, dass am Anfang eine Produkt/Konzept-Idee eines oder einiger Computer-Freaks stand und steht, die eine Firma in einer "Garage" und heutzutage in einer "Studentenbude" gründen, die sie mit großem, insbesondere Marketing-Engagement und unterstützt durch Massenphänomen-Effekten zum meist explosiven Wachsen bringen. Fast alle heutzutage bedeutenden großen IT-Firmen sind so entstanden: HP, Apple, Microsoft, Google, Facebook, um nur einige zu nennen. Allen diesen Produkt/Konzept-Ansätzen ist gemeinsam, dass sie sich zunächst an die so genannten End-Benutzer richten, also Produkte für den Bereich "Personal-IT" anbieten. Dass nach dem Erfolg bei den End-Benutzern i.d.R. die Ausdehnung in die zentrale IT der Unternehmen versucht wird, ist ebenfalls charakteristisch für die Geschäfts-Modelle US-amerikanischer IT-Unternehmen. Daraus ergibt sich schließlich die Erkenntnis, dass diese Firmen, die aufgrund ihrer singulären Produkt/Konzept-Lösungen als IT-Nischen-Firmen angefangen haben, gar kein Interesse an einem ganzheitlichen Verständnis der Unternehmens-IT entwickeln können.

Nischen-Firmen durchlaufen Konzept-immanent eine Bottom-up oder induktive Entwicklung. Eine ganzheitliche IT-Produkt-Palette erreichen dabei nur die Wenigsten. Außer IBM sehen wir gegenwärtig nur noch die Bemühungen von HP und ev. auch Oracle. D.h. die IT-Branche ist typisch "induktiv" geprägt mit höchstens beiläufigem Interesse für die IT als Unternehmens-Nutzen-Erzeuger!

Damit stellt sich die Frage, bei wem in diesem Interessenumfeld überhaupt die Motivation entsteht einen deduktiven Ansatz entwickeln zu wollen? Die Antwort lautet nach unserer Erfahrung: Bei Spin-offs mit viel akkumuliertem Sachverstand, großem Idealismus, langem Atem und "tiefen Taschen", wie zum Beispiel "IS-O Consulting". Wir haben mit unserem Lösungsansatz, dem Entwickeln der Grunderkenntnisse, dem Kontaktaufbau zu Fachleuten mit hilfreichem Know-how und zu aufgeschlossenen Klienten als Mitarbeiter von IBM begonnen, was uns ein ziemlich optimales Entwicklungsumfeld geboten hat. Nur "der lange Atem" hat bei IBM letztlich gefehlt.

Dabei repräsentiert ein holistisch-deduktiver Lösungsansatz die bestmögliche Lösung einer Aufgabenstellung: Sowohl intellektuell als auch ökonomisch durch "Winners-only" Realisierungen! Die wichtigsten Vorteile eines holistisch-deduktiven Ansatzes sind u.a.

- Der holistische Blick als "Ausgangspunkt" auf eine zu lösende Aufgabenstellung, in unserem Fall auf ein Gesamtunternehmen zur Beantwortung der Fragestellung "wie viel Geld sollte ein Unternehmen für seine Informationsverarbeitung ausgeben?" Der holistische Blick ist, populär ausgedrückt, der "Blick aus der so genannten Vogelperspektive" im Gegensatz bekanntlich zum "Blick aus der Froschperspektive", in München übrigens auch "Dackelperspektive" genannt und im Englischen noch pointierer "Worm's-eye view", bei einem induktiven Ansatz. Mit dieser Verbildlichung werden auch sofort viele der Vorteile eines holistisch-deduktiven Ansatzes erkennbar.

- Ein holistisch-deduktiver Ansatz liefert die Erkenntnisse zur "Entwicklung einer Lösungstheorie". Eine Lösungstheorie wiederum bietet wertvolle Erkenntnisse zur Vorgehensweise bei der Realisierung.

- Ein holistisch-deduktiver Ansatz lässt sich "differenzieren" und damit fokussieren auf alle Teilgebiete von besonderem Interesse. Damit lassen sich alle Einzelbereiche mit Handlungsbedarf identifizieren und nach ihrer unternehmerischen Bedeutung priorisieren. Dies ist übrigens auch die Vorgehensweise mit der größten Realisierungs-Effizienz.

- Durch Differenzierung entsteht "fast wie von selbst" auch die Struktur einer Lösungsarchitektur mit zuordenbaren Verantwortlichkeiten und einfachem Controlling bei der Umsetzung.

- Für die Einzelaufgaben lassen sich "heuristische Lösungsmodelle" definieren und mit klaren Vorgaben in den Bereichen "Aussagegenauigkeit" und "Umfang und Qualität des Datenbedarfs" konstruieren. Wiederum der effizienteste Lösungsansatz.

- Ein holistisch-deduktiver Ansatz lässt sich Ansatz-immanent "optimieren" und "aktualisieren".

Benötigtes Datenmaterial

Zielsetzung bei der Erkenntnisgewinnung mittels Benchmarking ist es verständlicherweise, möglichst hochwertige Ergebnisse mit möglichst wenig Aufwand zu erzielen. Es muss also erneut ein bestmöglicher Kompromiss gefunden werden.

Dafür bietet ein holistischer Ansatz beste Voraussetzungen. Denn durch die verfügbar werdende Betrachtungsperspektive "top-down" lassen sich die zur Lösung einer Fragestellung bestgeeigneten heuristischen Modelle durch Differenzierung gewinnen und dann das dafür benötigte Datenmaterial in Umfang und Datenqualität ableiten. Nach einigen Experimenten und Vergleichen mit Lösungsansätzen ähnlicher Zielsetzungen haben wir entschieden, dass das benötigte und auch ausreichende Datenmaterial pro Unternehmen in zwei 1-seitigen Excel-Tabellen Platz findet, eine Seite zur Festlegung der Ordinaten-Position "Human-Ressourcen-Aufwand pro Arbeitslast-Einheit" mit etwa 100 Einzeldaten und eine Seite zur Festlegung der dazu gehörigen Abszissen-Position "IT-Ressourcen-Aufwand pro Mitarbeiter" mit etwa 130 Einzeldaten im Durchschnitt. Hinzu kommen die Tabellen mit den Auswerte-Algorithmen.

Eine erhebliche Herausforderung bei der Beschaffung des Datenmaterials ergibt sich in der Praxis aus der bei unserem Methodischen Lösungsansatz notwendigen, bisher unüblichen Kombination aus Unternehmensdaten und IT-Daten. Die in den Unternehmen für dieses Datenmaterial zuständigen Abteilungen, die Betriebswirtschaft für die Unternehmensdaten und der IT-Bereich für das IT-Datenmaterial haben bisher i.d.R. noch nie zusammengearbeitet. Wir besorgen uns deshalb die Unternehmensdaten v.a. über die Geschäftsberichte und die BO der VU und die IT-Daten über die von uns seit vielen Jahren aufgebaute Kollaborative Community, die IT-Bereiche, das Internet und die Fachpresse.

Eine Herausforderung bei unserem Methodischen Lösungsansatz ergibt sich auch aus der Lösungs-immanenten Notwendigkeit, den Lösungsansatz mit aktuellem Datenmaterial fortzuschreiben. Das mündet aber gleichzeitig in die attraktive Chance zur Weiterentwicklung und Vertiefung.

Aktualisierungsbedarf

Da sich die wichtigsten Nutzen-generierenden Elemente der Informationsverarbeitung, nämlich die Funktionalität der IT und das Preis/Leistungsverhältnis, immer noch mit erheblicher, wenn auch leider immer geringer werdenden Dynamik weiter entwickeln, müssen die mit diesem Methodischen Lösungsansatz gewonnenen Erkenntnisse in "sinnvollen Zeitabständen" aktualisiert werden. Was sinnvolle Zeitabstände aus der Sicht der Informationsverarbeitung sind, ergibt sich aus der Entwicklungs-Dynamik der IT-Unternehmens-Nutzen stiftenden Elemente: Das Preis/Leistungsverhältnis der IT entwickelt sich mit der inzwischen abnehmenden Größe von 8-15% pro Jahr weiter, mit durchaus nicht unüblichen temporären Ausreißern nach beiden Richtungen. Bei der Funktionalitätsentwicklung der IT sind die Zyklen erheblich länger: Die wesentlichen Elemente haben sich in der Vergangenheit mit einem Abstand von etwa 10-15 Jahren fortentwickelt. Nach unserem Erkenntnisstand wird sich die Entwicklungs-Dynamik für diese beiden Größen auch in der überschaubaren Zukunft von mindestens 10 Jahren sehr wahrscheinlich nicht wesentlich verändern, tendenziell aber eher etwas verlangsamen.

Die Antwort auf die Frage, was sinnvolle Zeitabstände sind, ergibt sich aber nicht nur aus den objektiven Einflussfaktoren der Entwicklung der Informationsverarbeitung sondern auch aus der Entwicklung des Unternehmensumfeldes und auch aus subjektiven Einflüssen, wie der eingeschränkten Akzeptanz von scheinbar nicht mehr "taufrischen" Erkenntnissen oder "nicht selbst federführend erzeugten" Ergebnissen.

Bei unserem Methodischen Lösungsansatz gibt es Haupteinflüsse aus den beiden zentralen IT-Unternehmens-Nutzen/Kosten-Potential-Größen, nämlich der Entwicklung des IT-Umfeldes und der Entwicklung der Unternehmensgrößen. Dabei sind die Unternehmensziele bekanntlich i. d. R. relativ stabil. Und wenn man von der Technikebene der Informationsverarbeitung abstrahiert und v. a. das realisierte IT-Nutzen-Niveau eines Unternehmens und der Branche betrachtet, kommt man auch in diesem Bereich zu Größen, die sich üblicherweise aus bekannten Gründen nur evolutionär weiterentwickeln und dies mit überschaubarer Geschwindigkeit. D. h., eine Aktualisierung alle 2-3 Jahre wäre ausreichend wenn man zusätzlich in Rechnung stellte, dass es sich bei der IT-Unternehmens-Nutzen/Kosten-Potential-Bestimmung um Erkenntnisse in einem "ökonomischen System" handelt, bei dem eine Erkenntnis-Genauigkeit von plus/minus 10% bekanntlich eine auch mit viel mehr Aufwand kaum mehr verbesserbare Zielgröße darstellt.

Das sind allerdings nur die objektiven Gründe. In der Praxis werden die jedoch nur in den seltensten Fällen akzeptiert. Die i. d. R. dominanten subjektiven Forderungen lauten vielmehr so zeitnah wie irgend möglich. Deshalb aktualisieren wir unsere IT-Unternehmens-Nutzen/Kosten-Potential-Erkenntnisse Jahr für Jahr jeweils mit Status Jahresende, was übrigens insbesondere für die Genauigkeit der sich dynamisch entwickelnden IT-Daten und für die Aussagequalität der damit gewonnenen Erkenntnisse von nicht unerheblicher Bedeutung ist.

Aufgrund dieser Zusammenhänge haben wir bisher auch den IT-Unternehmens-Nutzen/Kosten-Rechner jährlich auf den neuesten Stand gebracht und die "Rating-Version" zur Aktualisierung der IT-Unternehmens-Nutzen/Kosten-Potential-Erkenntnisse im Internet verfügbar gemacht und planen dies auch für die nächsten Jahre.